IV的全称是Information Value,中文意思是信息价值,或者信息量。

我们在用逻辑回归、决策树等模型方法构建分类模型时,经常需要对自变量进行筛选。比如我们有200个候选自变量,通常情况下,不会直接把200个变量直接放到模型中去进行拟合训练,而是会用一些方法,从这200个自变量中挑选一些出来,放进模型,形成入模变量列表。那么我们怎么去挑选入模变量呢?

挑选入模变量过程是个比较复杂的过程,需要考虑的因素很多,比如:变量的预测能力,变量之间的相关性,变量的简单性(容易生成和使用),变量的强壮性(不容易被绕过),变量在业务上的可解释性(被挑战时可以解释的通)等等。但是,其中最主要和最直接的衡量标准是变量的预测能力。

IV就是这样一种指标,他可以用来衡量自变量的预测能力。类似的指标还有信息增益、基尼系数等等,IV的计算是以WOE为基础的。

WOE的全称是“Weight of Evidence”,即证据权重。WOE是对原始自变量的一种编码形式。

要对一个变量进行WOE编码,需要首先把这个变量进行分组处理(也叫离散化、分箱等等,说的都是一个意思)。

分箱的代码可以见之前的文章。

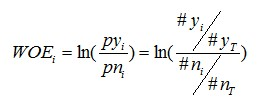

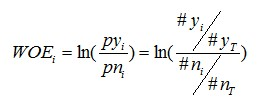

分组后,对于第i组,WOE的计算公式如下:

对这个公式做一个简单变换,可以得到:

对这个公式做一个简单变换,可以得到:

变换以后我们可以看出,WOE也可以这么理解,他表示的是当前这个组中响应的客户和未响应客户的比值,和所有样本中这个比值的差异。这个差异是用这两个比值的比值,再取对数来表示的。WOE越大,这种差异越大,这个分组里的样本响应的可能性就越大,WOE越小,差异越小,这个分组里的样本响应的可能性就越小。

对于一个分组后的变量,第i 组的WOE前面已经介绍过,同样,对于分组i,也会有一个对应的IV值,计算公式如下:

变换以后我们可以看出,WOE也可以这么理解,他表示的是当前这个组中响应的客户和未响应客户的比值,和所有样本中这个比值的差异。这个差异是用这两个比值的比值,再取对数来表示的。WOE越大,这种差异越大,这个分组里的样本响应的可能性就越大,WOE越小,差异越小,这个分组里的样本响应的可能性就越小。

对于一个分组后的变量,第i 组的WOE前面已经介绍过,同样,对于分组i,也会有一个对应的IV值,计算公式如下:

有了一个变量各分组的IV值,我们就可以计算整个变量的IV值,方法很简单,就是把各分组的IV相加:

有了一个变量各分组的IV值,我们就可以计算整个变量的IV值,方法很简单,就是把各分组的IV相加:

概念很简单,下面用Python代码来实现,并且与分箱的方法结合起来,完成评分卡的前期基础工作。

概念很简单,下面用Python代码来实现,并且与分箱的方法结合起来,完成评分卡的前期基础工作。

对这个公式做一个简单变换,可以得到:

对这个公式做一个简单变换,可以得到:

变换以后我们可以看出,WOE也可以这么理解,他表示的是当前这个组中响应的客户和未响应客户的比值,和所有样本中这个比值的差异。这个差异是用这两个比值的比值,再取对数来表示的。WOE越大,这种差异越大,这个分组里的样本响应的可能性就越大,WOE越小,差异越小,这个分组里的样本响应的可能性就越小。

对于一个分组后的变量,第i 组的WOE前面已经介绍过,同样,对于分组i,也会有一个对应的IV值,计算公式如下:

变换以后我们可以看出,WOE也可以这么理解,他表示的是当前这个组中响应的客户和未响应客户的比值,和所有样本中这个比值的差异。这个差异是用这两个比值的比值,再取对数来表示的。WOE越大,这种差异越大,这个分组里的样本响应的可能性就越大,WOE越小,差异越小,这个分组里的样本响应的可能性就越小。

对于一个分组后的变量,第i 组的WOE前面已经介绍过,同样,对于分组i,也会有一个对应的IV值,计算公式如下:

有了一个变量各分组的IV值,我们就可以计算整个变量的IV值,方法很简单,就是把各分组的IV相加:

有了一个变量各分组的IV值,我们就可以计算整个变量的IV值,方法很简单,就是把各分组的IV相加:

概念很简单,下面用Python代码来实现,并且与分箱的方法结合起来,完成评分卡的前期基础工作。

概念很简单,下面用Python代码来实现,并且与分箱的方法结合起来,完成评分卡的前期基础工作。

import pandas as pd

import numpy as np

#使用已经分箱的结果,计算woe和vi

def cal_woe(input_df):

groups = input_df.shape[0]

#对于统计项为0的actual_0和actual_1赋值为1

input_df.loc[input_df['actual_0']==0, 'actual_0'] = 1

input_df.loc[input_df['actual_1']==0, 'actual_1'] = 1

all_0 = input_df['actual_0'].sum()

all_1 = input_df['actual_1'].sum()

woe = []

vi = 0

for i in range(groups):

tmp = ((input_df.loc[i,'actual_1']*1.0 / all_1) - (input_df.loc[i,'actual_0']*1.0 / all_0)) *

np.log((input_df.loc[i,'actual_1']*1.0 / all_1) / (input_df.loc[i,'actual_0']*1.0 / all_0))

woe.append(tmp)

vi += tmp

input_df['woe'] = woe

return input_df, vi

这里的字段都是我预先定义过的,直接照搬肯定不行,但是也很简单,当前特征下某个属性值类别为0的样本数count值,就是actual_0,actual_1以此类推。